©Adobe-Stock

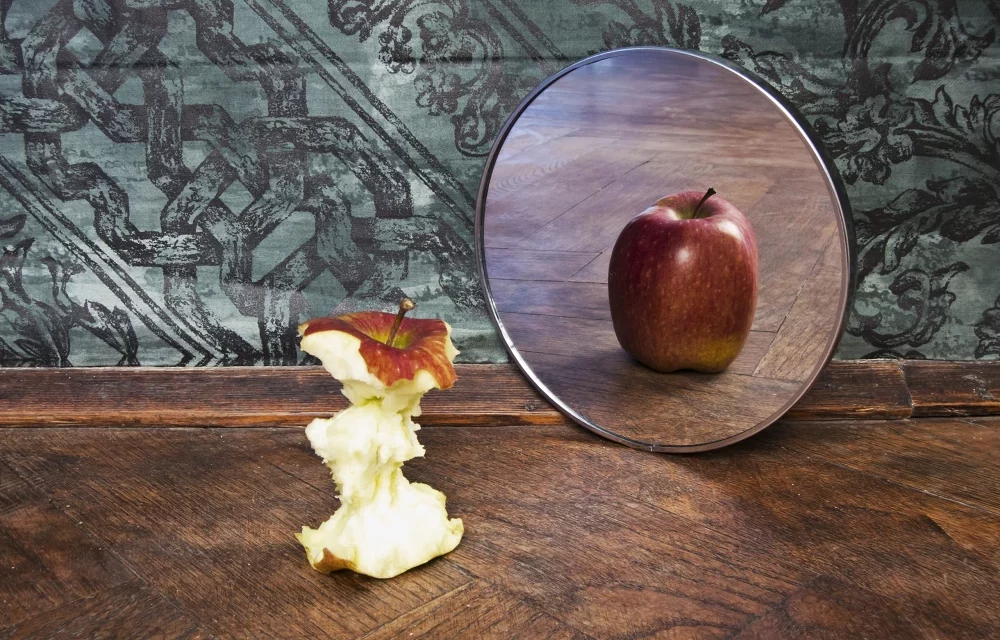

Bilder, Videos und Tonaufnahmen, die mit Hilfe von künstlicher Intelligenz erzeugt oder verändert wurden, sind aus unserer digitalen Welt nicht mehr wegzudenken. Um deren unliebsamen Folgen einzudämmen, braucht es einen Mix aus unterschiedlichen Massnahmen. Das zeigt die aktuelle Studie von TA-SWISS. Gleichzeitig wird in der Studie gefordert, die Selbstverantwortung und die Medienkompetenz zu stärken, damit das Potenzial der synthetisch generierten Medien positiv genutzt werden kann.

Bilder, Videos oder Tonaufnahmen mithilfe von KI zu verändern oder neu zu erschaffen, wird immer einfacher. Die so erzeugten synthetischen Medien lassen sich kaum von echten Inhalten unterscheiden. Die Technik verspricht interessante Anwendungen, etwa im Unterhaltungsbereich oder in der Bildung. Doch auch der Missbrauch ist weit verbreitet. Kriminelle nutzen künstlich kopierte Stimmen für betrügerische Schockanrufe bei Privatpersonen. Unternehmen müssen sich gegen Hacker und Spione wappnen, die versuchen, unbefugt mit Hilfe von Deepfakes Zugang zu Computersystemen und Betriebsgeheimnissen zu erlangen. Im zwischenmenschlichen Umgang lauern Gefahren, etwa für Frauen, die mit gefälschten pornografischen Aufnahmen unter Druck gesetzt werden, oder für Jugendliche, die auf dem Pausenplatz Mobbing mittels KI-Inhalten erfahren. Schliesslich können Deepfakes eine Bedrohung für die Demokratie darstellen, wenn sie verwendet werden, um politische Gegner zu diskreditieren.

TA-SWISS hat in der Studie «Deepfakes und manipulierte Realitäten» eine Auslegeordnung gemacht. Es wird aufgezeigt, welche Rahmenbedingungen bereits jetzt für Deepfakes gelten und wo noch Regulierungsbedarf besteht. Zudem wird in der Studie untersucht, inwieweit sich Bürgerinnen und Bürger von gefälschten Inhalten aufs Glatteis führen lassen. Im Hinblick auf die Chancen von Deepfakes wird exemplarisch aufgezeigt, in welchen Bereichen synthetisch erzeugte Inhalte einen Mehrwert aufweisen.

Bewusstsein schaffen und Opfer unterstützen

Irreführende oder illegale Deepfakes werden insbesondere dann zur Bedrohung, wenn sie sich massenhaft und unkontrolliert verbreiten. Hier setzt eine erste Empfehlung der Studie an: Indem die Medienkompetenz der Menschen gestärkt wird, lassen sich diese weniger dazu hinreissen, solche gefälschten Inhalte (bewusst oder unbewusst) zu teilen. Denn rein technisch gesehen ist es für Einzelpersonen kaum möglich, gut gemachte Deepfakes als Fälschung zu erkennen. Als weiteres Mittel wird in der Studie empfohlen, auf grosse Plattformen einzuwirken. Da künstlich erzeugte Inhalte hauptsächlich dort verbreitet werden, hätten Plattformen eine direkte Möglichkeit, deren Verbreitung – wenn nötig – zu unterbinden. Schliesslich stellt die Studie fest, dass Personen, die Ziel und Opfer von Deepfakes werden, zusätzliche Hilfsangebote brauchen. Dazu sollten Beratungsstellen ausgebaut werden.

Kritisches Prüfen von Quellen

Sowohl Menschen als auch Computerprogramme sind beim Erkennen von Deepfakes nicht vor Fehlschlüssen gefeit. Auch mit Anleitung gelang es vielen Menschen während eines Experimentes im Rahmen der Studie nicht, mittels KI generierte Inhalte als solche zu erkennen. Nicht viel besser schnitten die getesteten Detektor-Programme ab. Auch sie vermögen keine verlässliche und konstante Einschätzung abzugeben, ob Inhalte synthetisch erstellt wurden oder ob sie echt sind. Eine wichtige Rolle kommt daher den klassischen Medien zu. Sie sind bereits sensibilisiert darauf, Falschmeldungen zu erkennen. Ihre Rolle als verlässliche Informationsquellen dürfte damit gestärkt werden. Allerdings weisen die Studienautorinnen und -autoren darauf hin, dass es auch in der Bevölkerung ein Bewusstsein dafür braucht, dass nicht alle genutzten News-Quellen nach journalistischen Prinzipien funktionieren.

Zusätzlich werden technische Massnahmen diskutiert, die von Anfang an kenntlich machen, woher ein Bild stammt. Namhafte Hersteller von Kameras versuchen, mit sogenannten Content Credentials eine Art digitale Echtheitszertifikate zu etablieren. Darin können nicht nur Ort und Aufnahmezeit eines Fotos verlässlich gespeichert werden, sondern auch transparent die Bearbeitungsschritte bis zur Publikation nachvollzogen werden.

Positive Möglichkeiten nutzen

Gerade im Bereich der Unterhaltungsindustrie ergeben sich dank Deepfakes vielfältige Chancen. Beispielsweise für Synchronfassungen von Filmen. Mit Unterstützung von KI lassen sich die Lippenbewegungen der Schauspielerinnen und Schauspieler an die jeweilige Sprache anpassen. In der Bildung könnten digitale Avatare historischer Figuren einen unmittelbaren Zugang ermöglichen, etwa als interaktive Führer in Museen. Und nicht zuletzt erhoffen sich Polizei und Strafverfolgungsbehörden von Deepfakes neue Möglichkeiten bei der Verbrechensbekämpfung, etwa zur Rekonstruktion von Tatorten oder Tathergängen.

Studie, Kurzfassung und weitere Informationen zum Projekt sind auf der Projektwebseite verfügbar: www.ta-swiss.ch/deepfakes

Disclaimer:

„Für den oben stehenden Beitrag sowie für das angezeigte Bild- und Tonmaterial ist allein der jeweils angegebene Nutzer verantwortlich. Eine inhaltliche Kontrolle des Beitrags seitens der Seitenbetreiberin erfolgt weder vor noch nach der Veröffentlichung. Die Seitenbetreiberin macht sich den Inhalt insbesondere nicht zu eigen.“